一、自动采集的必要性

随着互联网内容的不断增长,手动采集内容既繁琐又耗时,无法满足高效运营的需求。自动采集技术能够通过特定的规则和算法,从互联网的各大信息源中快速获取信息,减轻人力负担。尤其对于某些特定领域的信息聚合网站,如新闻、科技类博客等,自动采集可以说是提升内容丰富度的关键手段。自动采集的优势不仅在于节约时间和提高效率,还可以帮助博客管理员保持信息的时效性和准确性。通过设置合适的采集规则,系统能够定期提取最新的文章、评论和资料,从而导致使网站始终保持新鲜感。

二、完成自动采集的技术手段

完成自动采集功能,我们可以利用多种技术手段。通常情况下,爬虫技术是最为常用的方式。网络爬虫可以自动访问不同网站,抓取所需的信息。确切完成步骤如下: 1. **选择采集目标**:明确想要自动采集的网站和内容类型,例如新闻、博客、论坛等。 2. **编写爬虫程序**:利用Python等编程语言编写爬虫,使用请求库(如Requests)获取网页HTML内容,并通过解析库(如BeautifulSoup或lxml)提取出所需信息。 3. **定期调度任务**:使用定时任务工具(如Cron)定期运行爬虫程序,确保信息的自动更新。 4. **资料存储**:将抓取到的资料存储到资料库中,可以是MySQL、SQLite等关系型资料库,确保资料能够快速检索和展示。三、一键发布功能的完成

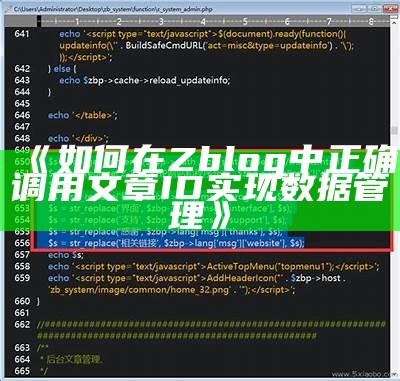

在完成自动采集之后,如何将采集到的内容快速发布到Zblog也是一个关键的障碍。这里我们可以借助Zblog的API接口,完成一键发布的功能。Zblog提供了一些开放的API接口,使得我们可以通过编程的方式,将新采集的文章一键发布到博客。确切步骤包括:

四、自定义采集规则与策略

为了提高采集内容的相关性和质量,设置合理的采集规则是不可或缺的。不同类型的网站可能需要不同的采集策略,以下是一些常用的自定义规则: 1. **内容过滤**:设置关键词过滤,确保只采集与主题相关的内容。 2. **频率控制**:为了避免对目标网站造成负担,设置爬虫的采集频率,确保保持良好的网络行为。 3. **采集深度**:根据需求,合理设置采集的层级,不必过多地深入抓取,以节省资源。五、维护与优化

完成自动采集和一键发布功能的搭建后,维护和优化是一个持续的过程。定期检查爬虫程序的有效性,确保网页结构的变化不会影响到资料抓取。在此之时研究发布内容的反馈资料,以判断哪些类型的文章最受欢迎,进而调整采集方向,提高内容质量。同时,定期进行性能优化,确保爬虫和发布程序能够高效运行,避免因负载过重导致服务中断。维护API的安全性和稳定性,防止恶意攻击和资料泄露也是关键的任务。