spark分布式集群搭建.对于想学习Spark的人而言,如何构建Spark集群是其最大的难点之一, 为了解决大家构建Spark集群的一切困难,Spark集群的构建分为了五个步骤,从 零起步,不需要任何前置知识,涵盖操作的每一个细节,构建完整.

3.构造分布式spark集群.构建Spark集群(1)第一步 搭建hadoop单机和伪分布式环境1.1开发hadoop需要的基本软件1.2安装每个软件1.3配置hadoop单机模式并运行wordcount示例1.4配置hadoop伪分布模式并运行wordcount示例目录.4.测试spark集群.

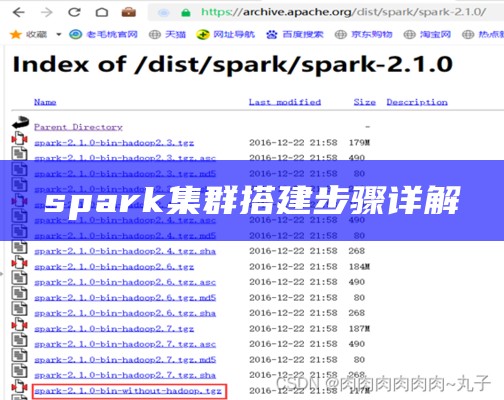

前言集群搭建详细步骤Standalone模式1、下载~spark-3.0.0~的jar包2、上传并解压3、配置SPARK_HOME环境变量4、修改配置4.1 修改 spark-defaults.conf4.2 修改spark-env.sh4.3 修改slaves文件5、将spark-3.0.0-bin-hadoop3.2 目录分发到.文章浏览阅读1.5w次,点赞29次,收藏329次。前言在上一篇文章Hadoop集群搭建配置教程中详细介绍了Hadoop集群搭建的全部过程,今天为大家带来分布式计算引擎Spark集群搭建

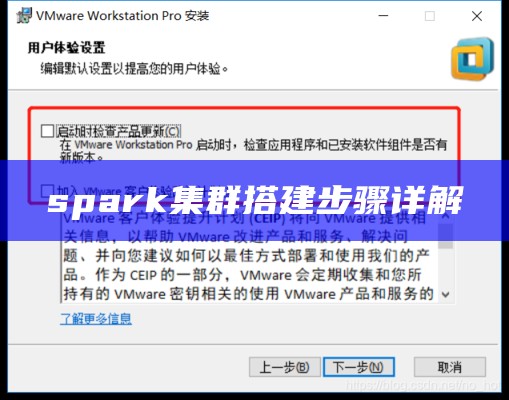

接着,逐步阐述了Spark集群的搭建过程,包括在Master和Slave节点上的安装、环境变量配置、slaves和spark-env.sh文件的配置,以及启动和关闭集群的步骤.spark概述spark集群搭建1.Spark安装2.环境变量配置3.Spark集群配置4.启动Spark集群存在难关及方法请参考以下文章spark概述.

最近好不容易搞到了三台测试机,可以用来搭建spark集群搞模型._description_:本文详细介绍了Sparkon YARN集群搭建的过程,包括配置主机 hosts 文件、免密码登录、安装 Java、安装 Scala 等步骤.spark集群搭建超详细.

6) 启动spark集群.接下来,到网站上下载搭建Spark集群环境所需的各种软件.

#注意:如果要搭建集群,需要将其它的主机名和IP也加进来,并且在每台主机上都要加.[root@localhost ~] useradd spark.下载方法:分别到对应的官网,再到下载链接,使用wget下载,详细步骤省略.

Spark集群配置** - **环境变量配置**:类似地,编辑~~/.bashrc~文件,添加~exportSPARK_HOME=/path/to/spark~等环境变量.还可以,还介绍了使用集群脚本启动/停止服务以及SSH无密码登录的配置步骤。.spark集群安装部署与初步开发.

至此,基于standalone的spark集群搭建完成。.Spark学习笔记(二)Spark2.3HA集群的分布式安装图文详解 本文主要介绍了Spark2.3HA集群的分布式安装,结合图文与实例形式详细研究了Spark2.3HA集群分布式安装详细下载、安装、配置、启动及执行spark程序等.

搭建spark提交任务的客户端,将spark目录发送到目标节点即可,我们选择nn1.在nn1和nn2上执行,安装完成后,重新启动集群,再次测试成功.依照上述步骤,按照前期规划,共克隆四台节点,并修改IP(参考四.4.5.6.7.8.9)与hostname(参考五.5).